2018л…„ кіјн•ҷкё°мҲ кіј кҙҖл Ён•ҙ к°ҖмһҘ лңЁкұ°мҡҙ кҙҖмӢ¬мқ„ л°ӣмқ„ нӮӨмӣҢл“ңлҠ” мқёкіөм§ҖлҠҘ(AI)мқј кІғмқҙлӢӨ.

![]() м§ҖкёҲ мҡ°лҰ¬лҠ” м„ё к°Җм§Җ м„ңлЎң лӢӨлҘё мқёкіөм§ҖлҠҘмқҳ лӘЁмҠөмқ„ л§ҢлӮңлӢӨ. л§җмқ„ м•Ңм•„л“ЈлҠ” лҳҳлҳҳн•ң 비м„ң кё°кі„, к·ёлҹҙл“Ҝн•ң лҢҖнҷ” мғҒлҢҖ, к·ёлҰ¬кі нҒ° л¬ём ңлҘј мқјмңјнӮ¬ мҲҳ мһҲлҠ” мң„н—ҳн•ң мЎҙмһ¬.

м§ҖкёҲ мҡ°лҰ¬лҠ” м„ё к°Җм§Җ м„ңлЎң лӢӨлҘё мқёкіөм§ҖлҠҘмқҳ лӘЁмҠөмқ„ л§ҢлӮңлӢӨ. л§җмқ„ м•Ңм•„л“ЈлҠ” лҳҳлҳҳн•ң 비м„ң кё°кі„, к·ёлҹҙл“Ҝн•ң лҢҖнҷ” мғҒлҢҖ, к·ёлҰ¬кі нҒ° л¬ём ңлҘј мқјмңјнӮ¬ мҲҳ мһҲлҠ” мң„н—ҳн•ң мЎҙмһ¬.

мқҙмқҖкІҪ м „л¶ҒлҢҖ кіјн•ҷн•ҷкіј көҗмҲҳ

![мқҙмқҖкІҪ м „л¶ҒлҢҖ кіјн•ҷн•ҷкіј көҗмҲҳ]() м§ҖлӮңн•ҙл¶Җн„° вҖҳмқёкіөм§ҖлҠҘвҖҷмқҙлӮҳ вҖҳAIвҖҷ мҲҳмӢқм–ҙлҘј лӢЁ к°Җм „м ңн’ҲмқҙлӮҳ л””м§Җн„ё кё°кё°л“Өм—җ лҢҖн•ң кҙ‘кі к°Җ л¶Җм©Қ л§Һм•„мЎҢлӢӨ. мҠӨн”јм»Ө нҳ•нғңмқҳ мқёкіөм§ҖлҠҘ кё°кё°лҠ” мӮ¬лһҢмқҳ л§җмқ„ м•Ңм•„л“Јкі к·ём—җ л§һлҠ” м„ң비мҠӨлҘј н•ҙ мӨҖлӢӨ. к°Җм „ кё°кё°лҘј мһ‘лҸҷмӢңнӮӨкі м Ғм Ҳн•ң м •ліҙмҷҖ мҪҳн…җмё лҘј м°ҫм•„мӨҖлӢӨ. мўҖлҚ” л°ңм „н•ҳл©ҙ н‘ңм •, м–ҙнҲ¬, н–үлҸҷмқ„ мқҪкі м Ғм Ҳн•ң м„ң비мҠӨлҘј н•ҙ мӨ„ кІғмқҙлӢӨ. мӢ кё°н•ҳкі нҺёлҰ¬н•ҙ ліҙмқҙл©° кұ°л¶Җк°җмқҙлӮҳ л‘җл ӨмӣҖмқ„ мқјмңјнӮӨм§Җ м•ҠлҠ”лӢӨ.

м§ҖлӮңн•ҙл¶Җн„° вҖҳмқёкіөм§ҖлҠҘвҖҷмқҙлӮҳ вҖҳAIвҖҷ мҲҳмӢқм–ҙлҘј лӢЁ к°Җм „м ңн’ҲмқҙлӮҳ л””м§Җн„ё кё°кё°л“Өм—җ лҢҖн•ң кҙ‘кі к°Җ л¶Җм©Қ л§Һм•„мЎҢлӢӨ. мҠӨн”јм»Ө нҳ•нғңмқҳ мқёкіөм§ҖлҠҘ кё°кё°лҠ” мӮ¬лһҢмқҳ л§җмқ„ м•Ңм•„л“Јкі к·ём—җ л§һлҠ” м„ң비мҠӨлҘј н•ҙ мӨҖлӢӨ. к°Җм „ кё°кё°лҘј мһ‘лҸҷмӢңнӮӨкі м Ғм Ҳн•ң м •ліҙмҷҖ мҪҳн…җмё лҘј м°ҫм•„мӨҖлӢӨ. мўҖлҚ” л°ңм „н•ҳл©ҙ н‘ңм •, м–ҙнҲ¬, н–үлҸҷмқ„ мқҪкі м Ғм Ҳн•ң м„ң비мҠӨлҘј н•ҙ мӨ„ кІғмқҙлӢӨ. мӢ кё°н•ҳкі нҺёлҰ¬н•ҙ ліҙмқҙл©° кұ°л¶Җк°җмқҙлӮҳ л‘җл ӨмӣҖмқ„ мқјмңјнӮӨм§Җ м•ҠлҠ”лӢӨ.

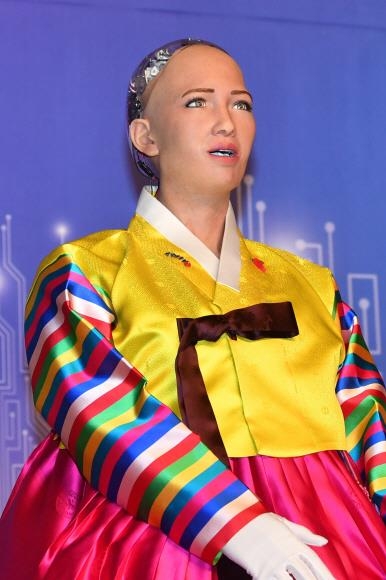

лӢӨмқҢмқҖ мӮ¬лһҢ лӘЁмҠөмқ„ н•ҳкі лҢҖнҷ”мҷҖ нҶ лЎ мқҙ к°ҖлҠҘн•ң AIлЎңлҙҮмқҙлӢӨ. м§ҖлӮң 1мӣ” н•ңкөӯмқ„ л°©л¬ён•ң вҖҳмҶҢн”јм•„вҖҷк°Җ лҢҖн‘ңм ҒмқҙлӢӨ. вҖҳм§ҖнҳңвҖҷлқјлҠ” мқҙлҰ„м—җм„ң м•Ң мҲҳ мһҲл“Ҝ мҶҢн”јм•„лҠ” мҠӨмҠӨлЎң н•ҷмҠөн•ҳкі мғқк°Ғн•ҳкі нҢҗлӢЁн•ҳлҠ” л‘җлҮҢ кё°лҠҘм—җ мӨ‘м җмқ„ л’ҖлӢӨ. м–јкөҙлҸ„ мӮ¬лһҢмқҳ н”јл¶ҖмҷҖ 비мҠ·н•ң лҠҗлӮҢмқ„ мЈјлҠ” мҶҢмһ¬лЎң л§Ңл“Өм–ҙм ё лҲҲмҚ№мқ„ м”°лЈ©кұ°лҰ¬кұ°лӮҳ л№ҷк·ёл Ҳ мӣғлҠ” л“ұ м—¬лҹ¬ н‘ңм •мқ„ м§Җмқ„ мҲҳ мһҲлӢӨ. мҶҢн”јм•„лҠ” мЈјлЎң мҰүм„қм—җм„ң мқҙлӨ„м§ҖлҠ” мқҢм„ұ, н‘ңм • лҢҖнҷ”лҘј нҶөн•ҙ мһҗмӢ мқҳ лҠҘл Ҙмқ„ ліҙм—¬ мӨҖлӢӨ.

мҶҢн”јм•„мқҳ к°ңл°ңмһҗ лҚ°мқҙ비л“ң н•ёмҠЁмқҖ мқёк°„мІҳлҹј мҶҢнҶөн•ҳлҠ” лЎңлҙҮ, лӮҳм•„к°Җ мқёк°„ліҙлӢӨ лӣ°м–ҙлӮң м§ҖлҠҘмқ„ к°Җ진 лЎңлҙҮмқ„ лӘ©н‘ңлЎң н•ңлӢӨкі л°қнҳ”лӢӨ. н•ёмҠЁмқҖ м—¬лҹ¬ мқён„°л·°м—җм„ң к·ёлҹ° вҖҳмҠҲнҚј мқён…”лҰ¬м „мҠӨвҖҷк°Җ мӮ¬лһҢл“Өмқҙ м§Ғл©ҙн•ң м—¬лҹ¬ л¬ём ңлҘј н•ҙкІ°н•ҳлҠ” лҚ° лҸ„мӣҖмқ„ мЈјкі , к°ҖмЎұмІҳлҹј мҶҢнҶөн•ҳл©ҙм„ң мқёк°„мқ„ лҸҢліҙкІҢ лҗ кІғмқҙлқјкі н–ҲлӢӨ. мӢӨм ң мҶҢн”јм•„лҠ” мқёк°„мқҙ AIлЎңлҙҮм—җкІҢ кё°лҢҖн•ҳлҠ” л°©мӢқм—җ л§һкІҢ м„ёл ЁлҗҳкІҢ мӮ¬кі н•ҳлҠ” кІғмІҳлҹј ліҙмқёлӢӨ.

2016л…„ CNBCмҷҖмқҳ мқён„°л·°м—җм„ң н•ёмҠЁмқҙ вҖҳмқёк°„мқ„ нҢҢкҙҙн• кІғмқёк°ҖвҖҷлқјкі мҶҢн”јм•„м—җкІҢ л¬јм—Ҳмқ„ л•Ң вҖҳк·ёл ҮкІҢ н•ҳкІ лӢӨвҖҷкі лӢөн•ҙ н•ёмҠЁмқ„ лӢ№нҷ©мӢңмј°лӢӨ. 2017л…„ нҲ¬лӮҳмқҙнҠёмҮјм—җм„ңлҠ” 진н–үмһҗмҷҖ к°Җмң„л°”мң„ліҙлҘј н•ҙм„ң мқҙкёҙ нӣ„ вҖҳмқҙ мҠ№лҰ¬лҠ” лҜёлһҳм—җ мқёк°„мқ„ м§Җл°°н•ҳлҠ” мӢңмһ‘м җвҖҷмқҙлқјкі лӢөн•ҳкё°лҸ„ н–ҲлӢӨ. л‘җ мһҘл©ҙмқҖ AIлЎңлҙҮмқҳ вҖҳ섬лң©н•ң л§җвҖҷмқҙлһҖ м ңлӘ©мңјлЎң мқён„°л„· кіөк°„мқ„ лҸҢм•„лӢӨлӢҲкі мһҲлӢӨ.

к·ёлҹ¬лӮҳ лӘҮ лӢ¬ л’Өмқё 10мӣ” мң м—”ліёл¶Җм—җм„ң м—ҙлҰ° кІҪм ңмӮ¬нҡҢмқҙмӮ¬нҡҢм—җ м°ёк°Җн•ҙм„ңлҠ” м •м№ҳм Ғ, лҸ„лҚ•м ҒмңјлЎң л§Өмҡ° мҳ¬л°”лҘё мқҳкІ¬мқ„ лӮҙлҶ“м•ҳлӢӨ. н•ң м°ёк°Җмһҗк°Җ вҖҳм „ м„ёкі„ л№ҲлҜј м•„мқҙл“Өмқ„ мң„н•ҙ л¬ҙм—Үмқ„ н•ҙм•ј н•ҳлҠ”к°ҖвҖҷлқјкі 묻мһҗ мҶҢн”јм•„лҠ” вҖҳкіөнҸүн•ҳкІҢ 분배лҗҳм§Җ м•ҠлҠ” л¬ём ңвҖҷлҘј м§Җм Ғн–ҲлӢӨ. мқёкіөм§ҖлҠҘмқҙ лҚ” лҳ‘лҳ‘н•ҙм§Җкі мғҒмғқмқҳ к°Җм№ҳм—җ 집мӨ‘н•ңлӢӨл©ҙ мқёк°„мқ„ лҸ„мҷҖ мқҙ л¬ём ңлҘј н•ҙкІ°н• мҲҳ мһҲмқ„ кІғмқҙлқјкі лҚ§л¶ҷмҳҖлӢӨ.

н•ңкөӯм—җм„ңлҠ” вҖҳмҶҢн”јм•„мҷҖ м§Ҳл¬ёмһҗ мӨ‘ лҲ„к°Җ мҳҲмҒңк°ҖвҖҷлқјлҠ” м§Ҳл¬ём—җ мһҗмӢ мқҖ к°җм •м§ҖлҠҘмқҙ м—Ҷкё° л•Ңл¬ём—җ нҢҗлӢЁмқҙ м–ҙл өлӢӨлҠ” л§җлЎң мҠ¬м©Қ н”јн•ҙк°ҖлҠ” мҶңм”ЁлҘј м„ ліҙмҳҖлӢӨ. мқҙ кіјм •мқ„ ліҙл©ҙ м Ғм–ҙлҸ„ мҶҢн”јм•„лҠ” мң„н—ҳн•ҳкұ°лӮҳ мқёк°„мқ„ мң„нҳ‘н•ҳкё°лҠ”м»Өл…• м–ҙл–Ө мқёк°„лҸ„ л”°лқјк°Ҳ мҲҳ м—Ҷмқ„ л§ҢнҒј л°”лҘёмғқнҷң лЎңлҙҮмІҳлҹј ліҙмқёлӢӨ.

л§Ҳм§Җл§үмқҖ мқёк°„м—җкІҢ мң„н—ҳмңјлЎң лӢӨк°Җмҳ¬м§ҖлҸ„ лӘЁлҘҙлҠ” AIмқҙлӢӨ. мҶҢн”јм•„лҠ” мқёкіөм§ҖлҠҘмқҙ к°Җм ёмҳ¬ лҜёлһҳ мң„н—ҳмқ„ 묻лҠ” м§Ҳл¬ём—җ мҳҒнҷ”лҘј л„Ҳл¬ҙ л§Һмқҙ ліё кІғ м•„лӢҲлғҗкі мқ‘мҲҳн•ң м Ғмқҙ мһҲлӢӨ. к·ёлҹ¬лӮҳ мөңк·ј л°ңн‘ңлҗң ліҙкі м„ң вҖҳмқёкіөм§ҖлҠҘ м•…мҡ©: мҳҲмёЎ, мҳҲл°©, мҷ„нҷ”вҖҷм—җ л”°лҘҙл©ҙ л””м§Җн„ё ліҙм•Ҳ, нҳ„мӢӨм„ёкі„ ліҙм•Ҳ, м •м№ҳ ліҙм•Ҳмқҙ лҡ«лҰҙ мң„н—ҳм„ұмқҙ м§Җм ҒлҗҗлӢӨ. м—°кө¬мһҗл“ӨмқҖ н•ҙм»Өмқҳ мҶҗм—җ л“Өм–ҙк°„ н”јмӢұ мӮ¬кё°мҡ© мқёкіөм§ҖлҠҘ, мһҗмӮҙнҠ№кіө н”„лЎңк·ёлһЁлҗң мһҗмңЁмЈјн–ү мһҗлҸҷм°Ё к°ҷмқҖ мң„н—ҳмқҖ 5~10л…„ лӮҙм—җ лӮҳнғҖлӮ мҲҳ мһҲмңјлҜҖлЎң лҢҖ비н•ҙм•ј н•ңлӢӨкі мЈјмһҘн–ҲлӢӨ.

мқҙ м„ё к°Җм§Җ лӘЁмҠө мӨ‘ мҡ°лҰ¬лӮҳлқјлҠ” мқёкіөм§ҖлҠҘмқҳ мң„н—ҳ к°ҖлҠҘм„ұ, к·ём—җ лҢҖн•ң м Ғк·№м Ғмқё лҢҖ비мҷҖ лҢҖмқ‘ л©ҙм—җм„ң м·Ём•Ҫн•ҳлӢӨ. л§ҺмқҖ м—°кө¬мһҗл“Өмқҙ м§Җм Ғн–Ҳл“Ҝмқҙ мқёкіөм§ҖлҠҘ кё°мҲ к°ңл°ң м§Җмӣҗ лӘ»м§Җм•ҠкІҢ мқёкіөм§ҖлҠҘ лЎңлҙҮмқҳ к¶ҢлҰ¬, мңӨлҰ¬, мұ…мһ„мқ„ лӢӨлЈЁлҠ” м ңлҸ„к°Җ н•„мҡ”н•ҳлӢӨ. мқҙлҘј мң„н•ң мІҙкі„м Ғмқё м—°кө¬ н”„лЎңк·ёлһЁмқҖ л¬јлЎ мқҙкі AI кҙҖл Ё м„ёкі„ ліҙнҺё к·ңлІ”кіј м ңлҸ„лҘј л§Ңл“Өкё° мң„н•ң көӯм ң нҷңлҸҷкіј л…ёл Ҙм—җлҸ„ м Ғк·№ м°ём—¬н•ҙм•ј н•ңлӢӨ. мқҙл ҮкІҢ мӨҖ비лҗҳм–ҙм•јл§Ң мқёк°„мқ„ лҸ•кі мқёк°„кіј кіөмЎҙн•ҳкі мӢ¶лӢӨлҠ” мҶҢн”јм•„мқҳ л°”лһҢмқҙ мқҙлЈЁм–ҙм§Ҳ мҲҳ мһҲмқ„ кІғмқҙлӢӨ.

мқҙмқҖкІҪ м „л¶ҒлҢҖ кіјн•ҷн•ҷкіј көҗмҲҳ

лӢӨмқҢмқҖ мӮ¬лһҢ лӘЁмҠөмқ„ н•ҳкі лҢҖнҷ”мҷҖ нҶ лЎ мқҙ к°ҖлҠҘн•ң AIлЎңлҙҮмқҙлӢӨ. м§ҖлӮң 1мӣ” н•ңкөӯмқ„ л°©л¬ён•ң вҖҳмҶҢн”јм•„вҖҷк°Җ лҢҖн‘ңм ҒмқҙлӢӨ. вҖҳм§ҖнҳңвҖҷлқјлҠ” мқҙлҰ„м—җм„ң м•Ң мҲҳ мһҲл“Ҝ мҶҢн”јм•„лҠ” мҠӨмҠӨлЎң н•ҷмҠөн•ҳкі мғқк°Ғн•ҳкі нҢҗлӢЁн•ҳлҠ” л‘җлҮҢ кё°лҠҘм—җ мӨ‘м җмқ„ л’ҖлӢӨ. м–јкөҙлҸ„ мӮ¬лһҢмқҳ н”јл¶ҖмҷҖ 비мҠ·н•ң лҠҗлӮҢмқ„ мЈјлҠ” мҶҢмһ¬лЎң л§Ңл“Өм–ҙм ё лҲҲмҚ№мқ„ м”°лЈ©кұ°лҰ¬кұ°лӮҳ л№ҷк·ёл Ҳ мӣғлҠ” л“ұ м—¬лҹ¬ н‘ңм •мқ„ м§Җмқ„ мҲҳ мһҲлӢӨ. мҶҢн”јм•„лҠ” мЈјлЎң мҰүм„қм—җм„ң мқҙлӨ„м§ҖлҠ” мқҢм„ұ, н‘ңм • лҢҖнҷ”лҘј нҶөн•ҙ мһҗмӢ мқҳ лҠҘл Ҙмқ„ ліҙм—¬ мӨҖлӢӨ.

мҶҢн”јм•„мқҳ к°ңл°ңмһҗ лҚ°мқҙ비л“ң н•ёмҠЁмқҖ мқёк°„мІҳлҹј мҶҢнҶөн•ҳлҠ” лЎңлҙҮ, лӮҳм•„к°Җ мқёк°„ліҙлӢӨ лӣ°м–ҙлӮң м§ҖлҠҘмқ„ к°Җ진 лЎңлҙҮмқ„ лӘ©н‘ңлЎң н•ңлӢӨкі л°қнҳ”лӢӨ. н•ёмҠЁмқҖ м—¬лҹ¬ мқён„°л·°м—җм„ң к·ёлҹ° вҖҳмҠҲнҚј мқён…”лҰ¬м „мҠӨвҖҷк°Җ мӮ¬лһҢл“Өмқҙ м§Ғл©ҙн•ң м—¬лҹ¬ л¬ём ңлҘј н•ҙкІ°н•ҳлҠ” лҚ° лҸ„мӣҖмқ„ мЈјкі , к°ҖмЎұмІҳлҹј мҶҢнҶөн•ҳл©ҙм„ң мқёк°„мқ„ лҸҢліҙкІҢ лҗ кІғмқҙлқјкі н–ҲлӢӨ. мӢӨм ң мҶҢн”јм•„лҠ” мқёк°„мқҙ AIлЎңлҙҮм—җкІҢ кё°лҢҖн•ҳлҠ” л°©мӢқм—җ л§һкІҢ м„ёл ЁлҗҳкІҢ мӮ¬кі н•ҳлҠ” кІғмІҳлҹј ліҙмқёлӢӨ.

2016л…„ CNBCмҷҖмқҳ мқён„°л·°м—җм„ң н•ёмҠЁмқҙ вҖҳмқёк°„мқ„ нҢҢкҙҙн• кІғмқёк°ҖвҖҷлқјкі мҶҢн”јм•„м—җкІҢ л¬јм—Ҳмқ„ л•Ң вҖҳк·ёл ҮкІҢ н•ҳкІ лӢӨвҖҷкі лӢөн•ҙ н•ёмҠЁмқ„ лӢ№нҷ©мӢңмј°лӢӨ. 2017л…„ нҲ¬лӮҳмқҙнҠёмҮјм—җм„ңлҠ” 진н–үмһҗмҷҖ к°Җмң„л°”мң„ліҙлҘј н•ҙм„ң мқҙкёҙ нӣ„ вҖҳмқҙ мҠ№лҰ¬лҠ” лҜёлһҳм—җ мқёк°„мқ„ м§Җл°°н•ҳлҠ” мӢңмһ‘м җвҖҷмқҙлқјкі лӢөн•ҳкё°лҸ„ н–ҲлӢӨ. л‘җ мһҘл©ҙмқҖ AIлЎңлҙҮмқҳ вҖҳ섬лң©н•ң л§җвҖҷмқҙлһҖ м ңлӘ©мңјлЎң мқён„°л„· кіөк°„мқ„ лҸҢм•„лӢӨлӢҲкі мһҲлӢӨ.

к·ёлҹ¬лӮҳ лӘҮ лӢ¬ л’Өмқё 10мӣ” мң м—”ліёл¶Җм—җм„ң м—ҙлҰ° кІҪм ңмӮ¬нҡҢмқҙмӮ¬нҡҢм—җ м°ёк°Җн•ҙм„ңлҠ” м •м№ҳм Ғ, лҸ„лҚ•м ҒмңјлЎң л§Өмҡ° мҳ¬л°”лҘё мқҳкІ¬мқ„ лӮҙлҶ“м•ҳлӢӨ. н•ң м°ёк°Җмһҗк°Җ вҖҳм „ м„ёкі„ л№ҲлҜј м•„мқҙл“Өмқ„ мң„н•ҙ л¬ҙм—Үмқ„ н•ҙм•ј н•ҳлҠ”к°ҖвҖҷлқјкі 묻мһҗ мҶҢн”јм•„лҠ” вҖҳкіөнҸүн•ҳкІҢ 분배лҗҳм§Җ м•ҠлҠ” л¬ём ңвҖҷлҘј м§Җм Ғн–ҲлӢӨ. мқёкіөм§ҖлҠҘмқҙ лҚ” лҳ‘лҳ‘н•ҙм§Җкі мғҒмғқмқҳ к°Җм№ҳм—җ 집мӨ‘н•ңлӢӨл©ҙ мқёк°„мқ„ лҸ„мҷҖ мқҙ л¬ём ңлҘј н•ҙкІ°н• мҲҳ мһҲмқ„ кІғмқҙлқјкі лҚ§л¶ҷмҳҖлӢӨ.

н•ңкөӯм—җм„ңлҠ” вҖҳмҶҢн”јм•„мҷҖ м§Ҳл¬ёмһҗ мӨ‘ лҲ„к°Җ мҳҲмҒңк°ҖвҖҷлқјлҠ” м§Ҳл¬ём—җ мһҗмӢ мқҖ к°җм •м§ҖлҠҘмқҙ м—Ҷкё° л•Ңл¬ём—җ нҢҗлӢЁмқҙ м–ҙл өлӢӨлҠ” л§җлЎң мҠ¬м©Қ н”јн•ҙк°ҖлҠ” мҶңм”ЁлҘј м„ ліҙмҳҖлӢӨ. мқҙ кіјм •мқ„ ліҙл©ҙ м Ғм–ҙлҸ„ мҶҢн”јм•„лҠ” мң„н—ҳн•ҳкұ°лӮҳ мқёк°„мқ„ мң„нҳ‘н•ҳкё°лҠ”м»Өл…• м–ҙл–Ө мқёк°„лҸ„ л”°лқјк°Ҳ мҲҳ м—Ҷмқ„ л§ҢнҒј л°”лҘёмғқнҷң лЎңлҙҮмІҳлҹј ліҙмқёлӢӨ.

л§Ҳм§Җл§үмқҖ мқёк°„м—җкІҢ мң„н—ҳмңјлЎң лӢӨк°Җмҳ¬м§ҖлҸ„ лӘЁлҘҙлҠ” AIмқҙлӢӨ. мҶҢн”јм•„лҠ” мқёкіөм§ҖлҠҘмқҙ к°Җм ёмҳ¬ лҜёлһҳ мң„н—ҳмқ„ 묻лҠ” м§Ҳл¬ём—җ мҳҒнҷ”лҘј л„Ҳл¬ҙ л§Һмқҙ ліё кІғ м•„лӢҲлғҗкі мқ‘мҲҳн•ң м Ғмқҙ мһҲлӢӨ. к·ёлҹ¬лӮҳ мөңк·ј л°ңн‘ңлҗң ліҙкі м„ң вҖҳмқёкіөм§ҖлҠҘ м•…мҡ©: мҳҲмёЎ, мҳҲл°©, мҷ„нҷ”вҖҷм—җ л”°лҘҙл©ҙ л””м§Җн„ё ліҙм•Ҳ, нҳ„мӢӨм„ёкі„ ліҙм•Ҳ, м •м№ҳ ліҙм•Ҳмқҙ лҡ«лҰҙ мң„н—ҳм„ұмқҙ м§Җм ҒлҗҗлӢӨ. м—°кө¬мһҗл“ӨмқҖ н•ҙм»Өмқҳ мҶҗм—җ л“Өм–ҙк°„ н”јмӢұ мӮ¬кё°мҡ© мқёкіөм§ҖлҠҘ, мһҗмӮҙнҠ№кіө н”„лЎңк·ёлһЁлҗң мһҗмңЁмЈјн–ү мһҗлҸҷм°Ё к°ҷмқҖ мң„н—ҳмқҖ 5~10л…„ лӮҙм—җ лӮҳнғҖлӮ мҲҳ мһҲмңјлҜҖлЎң лҢҖ비н•ҙм•ј н•ңлӢӨкі мЈјмһҘн–ҲлӢӨ.

мқҙ м„ё к°Җм§Җ лӘЁмҠө мӨ‘ мҡ°лҰ¬лӮҳлқјлҠ” мқёкіөм§ҖлҠҘмқҳ мң„н—ҳ к°ҖлҠҘм„ұ, к·ём—җ лҢҖн•ң м Ғк·№м Ғмқё лҢҖ비мҷҖ лҢҖмқ‘ л©ҙм—җм„ң м·Ём•Ҫн•ҳлӢӨ. л§ҺмқҖ м—°кө¬мһҗл“Өмқҙ м§Җм Ғн–Ҳл“Ҝмқҙ мқёкіөм§ҖлҠҘ кё°мҲ к°ңл°ң м§Җмӣҗ лӘ»м§Җм•ҠкІҢ мқёкіөм§ҖлҠҘ лЎңлҙҮмқҳ к¶ҢлҰ¬, мңӨлҰ¬, мұ…мһ„мқ„ лӢӨлЈЁлҠ” м ңлҸ„к°Җ н•„мҡ”н•ҳлӢӨ. мқҙлҘј мң„н•ң мІҙкі„м Ғмқё м—°кө¬ н”„лЎңк·ёлһЁмқҖ л¬јлЎ мқҙкі AI кҙҖл Ё м„ёкі„ ліҙнҺё к·ңлІ”кіј м ңлҸ„лҘј л§Ңл“Өкё° мң„н•ң көӯм ң нҷңлҸҷкіј л…ёл Ҙм—җлҸ„ м Ғк·№ м°ём—¬н•ҙм•ј н•ңлӢӨ. мқҙл ҮкІҢ мӨҖ비лҗҳм–ҙм•јл§Ң мқёк°„мқ„ лҸ•кі мқёк°„кіј кіөмЎҙн•ҳкі мӢ¶лӢӨлҠ” мҶҢн”јм•„мқҳ л°”лһҢмқҙ мқҙлЈЁм–ҙм§Ҳ мҲҳ мһҲмқ„ кІғмқҙлӢӨ.

2018-02-27 29л©ҙ

Copyright в“’ м„ңмҡёмӢ л¬ё All rights reserved. л¬ҙлӢЁ м „мһ¬-мһ¬л°°нҸ¬, AI н•ҷмҠө л°Ҹ нҷңмҡ© кёҲм§Җ